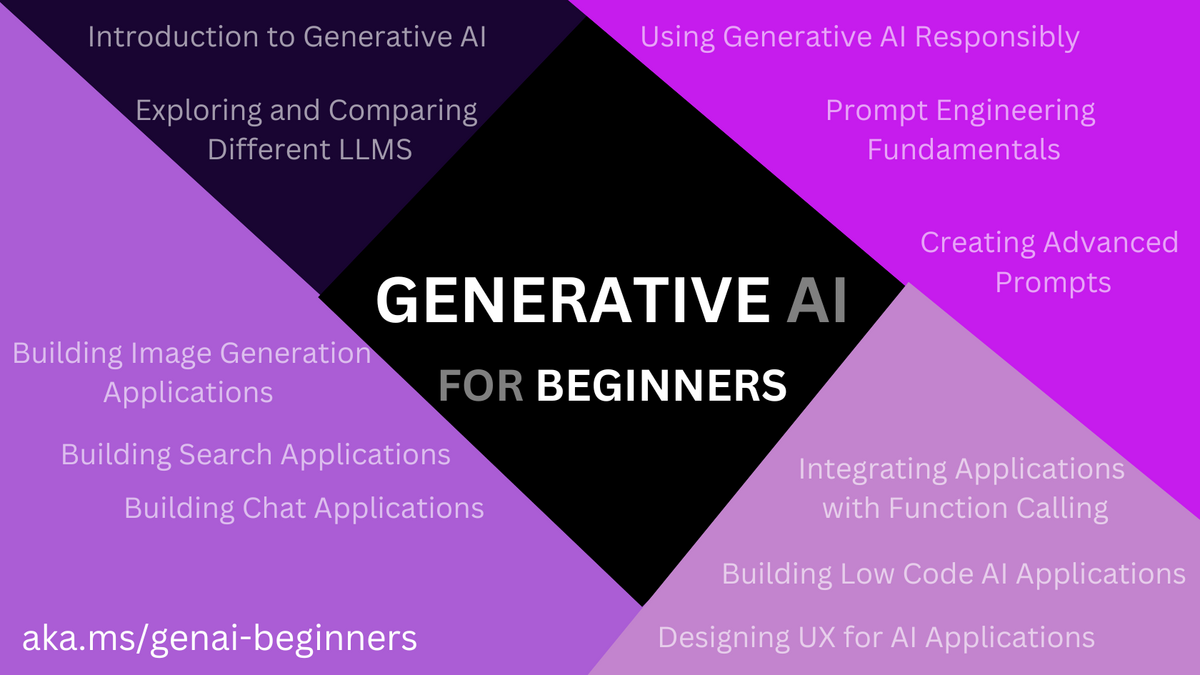

0-3章:Generative AI for Beginners講座( by Microsoft)まとめ

概要

URL

Generative AI for Beginners

https://microsoft.github.io/generative-ai-for-beginners/#/translations/ja-jp/

GitHub

目次

| No. | レッスンへのリンク | 学ぶ内容の概念 | 学習目標 |

|---|---|---|---|

| 0 | このコースを始めるための準備 | テクノロジーのセットアップとコースの枠組み | レッスンが成功したと分かるゴール設定 |

| 1 | 生成 AI と大規模言語モデルの紹介 | 概念: 生成 AI と現在のテクノロジー環境 | 生成 AI とは何か、そして大規模言語モデル(LLM)がどのように動くかを理解する。 |

| 2 | 様々なLLMの調査と比較 | 概念: さまざまな大規模言語モデルのテスト、反復、および比較 | ユースケースに適した AI モデルを選択 |

| 3 | 責任ある生成 AI の利用 | 概念: ファウンデーションモデルの限界と AI に伴うリスクを理解する | 責任ある生成 AI アプリケーションの開発方法を学ぶ |

| 4 | プロンプト・エンジニアリングの基礎 | Code/概念: ハンズオン形式でプロンプト・エンジニアリングのベストプラクティスを学ぶ | 出力結果を改善するため、プロンプト・エンジニアリングのテクニックを取り入れる |

| 5 | DALL-E のユースケースと応用 | Code/概念: DALL-E のモデル構造と活用方法 | DALL-E を用いたアプリケーションの開発スキルを習得し、その応用例を探る |

| 6 | テキスト生成アプリケーションの構築 | Code: コード:Azure OpenAI を使用してテキスト生成アプリを構築する | トークンと温度を効率的に使用しモデルの出力を変化させる方法を理解する |

| 7 | チャットアプリケーションの構築 | Code: チャット アプリケーションを効率的に構築および統合するための手法。 | AI を利用したチャット・アプリケーションの品質を効果的に監視し維持するための重要なキーメトリクスと注意点を把握する |

| 8 | Vector Databases を利用した検索アプリケーションの構築 | Code: セマンティック検索とキーワード検索の違いについて学ぶ。テキストの埋め込みについて学び、検索への適用方法を理解する | 埋め込み技術を利用したデータ検索アプリケーションを構築する |

| 9 | 画像生成アプリケーションの構築 | Code: アプリケーション開発で画像生成が役立つ理由 | 画像を生成するアプリケーションを構築する |

| 10 | ローコード AI アプリケーションの構築 | Low Code: Power Platform における生成 AI の概要 | 教育系スタートアップ企業がローコードで学生の課題追跡アプリを構築する |

| 11 | Function Calling との統合 | Code: Function Calling とアプリケーションにおける用途 | 外部 API からデータを取得するため Function Calling を設定する |

| 12 | AI アプリケーション用の UX デザイン | 概念: 透明性と信頼性を備えたAIアプリケーションの設計 | 生成 AI アプリケーションの開発時に UX デザインの原則を適用する |

| xx | 学習の継続 | 各授業の内容をさらに進めるための参考リンク! | 生成 AI の技術をマスターするために |

0.このコースを始めるための準備

準備: git clone

git clone https://github.com/microsoft/generative-ai-for-beginners

cd generative-ai-for-beginners

準備: Azure OpenAI アクセス権の申請

申請先

Request Access to Azure OpenAI Service

https://aka.ms/oaiapply

(数日かかるらしいので早めに申請)

準備: Azure OpenAI サービスをはじめて使用する場合

- Azure OpenAI サービスのリソースを作成しデプロイ

- リソースの作成方法はリンク先のガイドを参照:

1.生成 AI と大規模言語モデルの紹介

ビデオの要約 by YouTube Summary with ChatGPT & Claude

- 初心者向けのジェネラティブAIコースの最初のレッスン。

- プレゼンターはマイクロソフトのAIクラウドアドボケート、カルロータ・クチョ。

- オープンソースカリキュラムに基づいたコースで、ジェネラティブAIと大規模言語モデル(LLM)を紹介。

- LLMはAI技術の頂点として、以前のモデルの課題を克服し、様々なタスクで人間レベルのパフォーマンスを達成。

- コースは教育におけるLLMの役割に焦点を当て、「私たちのスタートアップ」という架空のケーススタディを使用。

- スタートアップの目標は、世界的な学習アクセスの向上、公平な教育アクセスの保証、個々の学習者のニーズに応じたパーソナライズされた学習体験の提供。

- AIの歴史は1950年代、1960年代に遡り、基本的なチャットボットから始まり、1990年代に機械学習アルゴリズムによる発展を経て進化。

- 21世紀初頭にはバーチャルアシスタントが登場し、自然言語処理が向上。

- ジェネラティブAIは、トランスフォーマーモデルアーキテクチャに基づく数十年のAI研究後に出現。

- LLMは、テキストを数値表現に変換するトークン化を使用し、創造性を模倣して魅力的なテキストを生成。

- 「プロンプト」と「コンプリーション」という概念を説明し、教育コンテキストでの使用を実演。

- 次のレッスンでは、異なるタイプのジェネラティブAIモデル、テスト、パフォーマンスの改善、特定のユースケースに適したモデルの選択方法について探求する予定。

コンテンツの要約 by ChatGPT

生成 AI の誕生と発展

生成 AI の誕生と発展について、10個の箇条書きで要約します:

長い開発歴史: 生成 AI の技術は1960年代にさかのぼり、数十年にわたる開発が行われてきました。

初期のチャットボット: 最初の AI プロトタイプは、手入力されたテキストに基づいて回答する単純なチャットボットでした。

知識ベースの応答: 初期のモデルは専門家の知識に基づいており、キーワードがトリガーとなっていました。

データからの学習: 新しいアルゴリズムにより、データからパターンを学ぶことが可能になりました。

ニューラルネットワークの進化: ニューラルネットワークとディープラーニングが開発され、AI の能力が飛躍的に向上しました。

再帰型ニューラルネットワーク(RNN): RNN は自然言語処理を大きく進化させ、文脈を考慮した言語理解を可能にしました。

バーチャルアシスタントの台頭: ニューラルネットワークは、言葉を理解し行動を取るバーチャルアシスタントの基盤となりました。

トランスフォーマーとアテンションメカニズム: トランスフォーマーはRNNを超える長文処理能力を持ち、注意機構でテキストの重要な部分に焦点を当てます。

大規模言語モデル(LLM)の登場: 最新の生成 AI モデルは、膨大なラベルなしデータから学習し、創造性と正確な文法を持つ文章を生成できるようになりました。

大規模言語モデルの仕組み

大規模言語モデルの仕組みについて、10個の箇条書きで要約します:

テキストの入力と出力: モデルはテキストを入力として受け取り、テキストを出力として生成します。

繰り返し処理: 予測されたトークンは入力に追加され、文が形成されます。

確率分布に基づく選考: モデルは、次に出現するトークンを確率的に選択します。

ランダム性の導入: 同じ入力に対して必ずしも同じ出力が得られるわけではない、ランダム性があります。

創造的思考の模倣: ランダム性は創造的な思考過程を模倣するために導入されています。

温度パラメータ: このランダム性は「温度」というパラメータで調整されます。

モデルの制約: 入力として受け取れるトークンの数には最大値があります。

スタートアップが大規模言語モデルを活用する方法

スタートアップが大規模言語モデルを活用する方法について、10個の箇条書きで要約します:

プロンプトの利用: モデルに期待する出力やフォーマットを指示するために、プロンプト(指示)を用います。

テキストの要約: 記事や書籍、製品レビューなどの非構造化データから要約や知見を抽出します。

教育分野への応用: 学校の課題や質問を作成するために活用できます。

対話形式の質問回答: 質問に対して、エージェントが会話形式で回答を提供します。

テキストの補完: 未完成の文章や話の続きを生成します。

プログラムコードの生成: プログラミングに関する説明やコード生成を行います。

生成 AI の限界認識: 出力は必ずしも完璧ではなく、場合によっては誤解を招くことがあります。

批判的思考の欠如: 生成 AI は批判的思考や創造的推理、感情を持たないため、その点を認識することが重要です。

信頼性の問題: 誤った参照や内容に基づく回答を生成することもあるため、信頼性を慎重に考慮する必要があります。

課題

課題文

この課題では、「生成 AI」に関する知識を深め、 まだ生成 AI が導入されていない領域を特定し、 そこにどう取り込めるかを検討してください。 従来の方法と比べて、どのような違いがあるでしょうか? これまでにできなかった処理が、実現可能になるか、 作業の速度が上がるかをご検討ください。 「問題点」「AIの活用方法」「導入による効果」 といった見出しを用いて、 皆様がこれから創業する理想の AI スタートアップを 300 文字 でまとめてください。 可能であれば、ビジネスプランも記述してください。

- 回答例1: ざっくり版 by ChatGPT

「問題点」: 多くのビジネスプロセスでは、 データの解析や文書の作成に多大な時間が費やされ、 これが生産性のボトルネックになっています。 「AIの活用方法」: 生成 AI を用いて、 これらのプロセスを自動化します。 AI は大量のデータを迅速に解析し、 報告書や文書を自動生成することができます。 また、顧客対応やサポート業務にも応用可能です。 「導入による効果」: 手作業で行っていた作業の自動化により、 作業の速度が大幅に向上し、エラーの削減も期待できます。 さらに、従業員は創造的な作業により多くの時間を 割くことができ、全体の生産性が向上します。 ビジネスプラン: 私たちのスタートアップは、 中小企業をターゲットに、 生成 AI 技術を活用した文書自動作成ツールを提供します。 これにより、 企業は報告書作成やデータ解析にかかる時間を大幅に削減し、 より価値の高い業務に注力できるようになります。 また、カスタマイズ可能な顧客対応AIも提供し、 顧客満足度の向上とオペレーションコストの削減を実現します。

- 回答例2: 具体的アイデア版 by ChatGPT

文書自動作成: 契約書や報告書などの文書をAIが自動生成し、人手による作成時間を削減。

データ分析の高速化: 大量のビジネスデータをAIが迅速に分析し、意思決定を支援。

顧客サポートの改善: AIによる24時間体制の顧客サポートで、迅速かつ正確な応対が可能に。

言語翻訳の最適化: 多言語に対応した翻訳AIで、国際的なビジネスコミュニケーションを円滑化。

自動要約機能: 長文のビジネスレポートやニュース記事を短時間で要約し、情報把握の効率化。

教育分野での活用: 教材作成や問題集の自動生成で、教師の負担軽減と教育の質向上。

健康医療データの分析: 患者の健康記録や臨床データを解析し、治療計画の策定を支援。

クリエイティブ業界への応用: 小説や脚本の草案をAIが生成し、クリエイターのアイデア創出を支援。

製品開発の支援: マーケット調査やユーザーフィードバックを分析し、製品開発の方向性を示唆。

2.様々なLLMの調査と比較

ビデオの要約 by YouTube Summary with ChatGPT & Claude

- Microsoftとgical systemsによるgenerative AIシリーズの一環として、大規模言語モデル(LLM)の種類と使い方についてのビデオ。

- プレゼンターは、Microsoftのアプリケーション開発と人工知能チームのグローバルクラウドアドボケート、Paabo Lopez。

- LLMのアーキテクチャ、トレーニングデータ、ユースケースの違いについて説明。

- 基礎モデル(foundation models)とは、教師なしまたは自己教師ありデータを使ってトレーニングされる大規模モデル。

- LLMは基礎モデルの一種で、テキスト要約や翻訳などのタスクに使用される。

- オープンソースモデルとプロプライエタリモデルの違いについての説明。オープンソースは公開されており、プロプライエタリは企業によって管理されている。

- LLMの応用例として、埋め込み(embeddings)、サロゲートモデル、画像生成、テキスト・コード生成などを紹介。

- 異なるモデルの役割について説明。例えば、コンテンツ作成にはデコーダー、レビューにはエンコーダーが使用される。

- LLMの利用可能性と展開方法について、クラウドまたはローカルハードウェアでのデプロイメントに言及。

- プロンプトエンジニアリング、情報取得強化生成、ファインチューニングモデル、独自の大規模言語モデルのトレーニングなど、様々なデプロイメント手法の説明。モデルの使い方には責任が伴い、その限界を理解することが重要。

コンテンツの要約 by ChatGPT

大規模言語モデル(LLM)の様々な種類の理解

概要

- LLMの分類基準 - 大規模言語モデル(LLM)のアーキテクチャ、トレーニングデータ、用途による分類方法。

- スタートアップのためのモデル選択 - シナリオに合わせた適切なLLMの選択とパフォーマンステストの重要性。

- LLMの多様性 - さまざまな種類のLLMがあり、選択は使用目的や利用可能な予算に依存する。

- 用途別モデル選択 - テキスト、オーディオ、ビデオ、画像生成などの用途に合わせたモデルの選択。

- 音声認識用LLM - 多言語対応の汎用性のあるWhisperモデルの特徴。

- 画像生成用LLM - DALL-EとMidjourneyといった有名な画像生成モデルの紹介。

- テキスト生成用LLM - GPT-3.5からGPT-4に至るまでのテキスト生成モデルの選択肢とコスト。

- 基本機能と企業固有のデータ - モデル選択時に得られる基本機能と、企業固有のデータの重要性。

- モデルへのデータ伝達方法 - 企業データをLLMに伝えるための様々な方法。

- モデル選択のためのガイド - Azure OpenAIプレイグラウンドを利用したモデル選択のための参考情報。

ファウンデーション・モデルと LLM の比較

- ファウンデーション・モデルの定義 - スタンフォード大学の研究者が定義した、教師なし学習または自己教師あり学習でトレーニングされるAIモデル。

- 教師なし学習の特徴 - ラベルのないマルチモーダルデータを使用し、データの注釈やラベル付けが不要。

- モデルの規模 - 数十億のパラメータを使用し、ディープニューラルネットワークに基づいてトレーニング。

- 他のモデルの基盤としての利用 - ファインチューニングを通じて他のモデル構築の基盤として使用可能。

- ChatGPTの例 - ChatGPTの最初のバージョンは、GPT-3.5をファウンデーション・モデルとして使用。

- ChatGPTのチューニング - OpenAIがチャットボットのような会話シナリオに特化したデータを用いてGPT-3.5をチューニング。

オープンソース・モデルとプロプライエタリ・モデル

- LLMの分類基準 - 大規模言語モデル(LLM)をオープンソースかプロプライエタリかで分類する方法。

- オープンソースモデルの特徴 - 一般に公開されていて、誰でも利用可能なモデル。

- オープンソースモデルの提供元 - 企業や研究コミュニティによって開発され、提供される。

- カスタマイズ可能性 - LLMの様々な用途に合わせて検証、変更、カスタマイズが許可されている。

- オープンソースモデルの限界 - 本番環境での利用に最適化されていないことがあり、パフォーマンスがプロプライエタリモデルに劣る場合もある。

- 資金調達の制約 - オープンソースモデルは資金調達が限られており、継続可能性や最新の研究に基づく更新が不十分な場合がある。

- 人気のオープンソースモデル例 - Alpaca、Bloom、LLaMAなど。

- プロプライエタリモデルの特徴 - 企業が所有し、一般には公開されていないモデル。

- プロプライエタリモデルの使用条件 - 通常本番環境での利用に最適化されており、カスタマイズや検証が制限されている。

- 人気のプロプライエタリモデル例 - OpenAIのモデル、Google Bard、Claude 2など。

埋め込み (Embedding) と画像生成とテキスト・コード生成

- LLMの出力分類 - 大規模言語モデル(LLM)は出力の種類によっても分類可能。

- 埋め込み(Embedding)モデルの定義 - テキストを数値形式に変換するAIモデル。

- 埋め込みの利用目的 - 機械による単語や文の関係理解の容易化と、他のモデルへの入力としての利用。

- 埋め込みモデルの特徴 - 代理タスク用に作成されたモデルが他の下流タスクでの転移学習に使用される。

- 画像生成モデルの概要 - 画像編集、合成、変換などに利用されるモデル。

- 画像生成モデルのトレーニング - 大規模な画像データセットでトレーニングされ、新しい画像生成や画像編集に使用。

- 代表的な画像生成モデル - DALL-E-3やStable Diffusion modelsなど。

- テキスト生成モデルの用途 - テキストの要約、翻訳、質疑応答などに使用される。

- テキスト生成モデルのトレーニング - 大規模なテキストデータセットでトレーニングされ、新しいテキスト生成や質問応答に利用。

- コード生成モデルの活用 - GitHubなどのソースコードデータでトレーニングされ、新しいコード生成やバグ修正に利用される。

「エンコーダー・デコーダー」 と 「デコーダーのみ」 のモデル

- LLMアーキテクチャの種類 - 大規模言語モデルのアーキテクチャの違いを説明するための比喩。

- クイズ作成の例え - 学生用のクイズを作成する仕事を担当する2人の同僚の例。

- 「デコーダーのみ」モデルの特徴 - コンテンツ作成に特化し、トピックや学習目標の理解には不向きなモデル。

- 「デコーダーのみ」モデルの例 - GPT-3などのGPTファミリーのモデル。

- 「エンコーダーのみ」モデルの特徴 - 書かれた内容と回答の関係を理解し、文脈を把握するが、コンテンツ作成には不向きなモデル。

- 「エンコーダーのみ」モデルの例 - BERTなど。

- 「エンコーダー・デコーダー」モデルの説明 - コンテンツの作成とレビューを同時に行うモデル。

- 「エンコーダー・デコーダー」モデルの例 - BARTやT5など。

- コンテンツ作成とレビューの役割分担 - コンテンツ作成者とレビュー担当者の役割の違い。

- アーキテクチャの比喩的説明 - クイズ作成のシナリオを使ったLLMアーキテクチャの理解促進。

サービスとモデル

- サービスとモデルの基本的な違い - サービスはクラウドサービスプロバイダーが提供する製品で、モデル、データ、その他のコンポーネントが組み合わされたもの。

- サービスの特徴 - 本番環境での利用に最適化され、ユーザーインターフェースを通じてモデル操作が容易。

- サービスの利用条件 - 無料での利用が可能ではなく、サブスクリプションによる支払いが必要な場合もある。

- サービスの費用最適化とスケールアップ - 使用量に応じた料金体系により、コストを最適化しやすい。

- Azure OpenAI Serviceの例 - 使用量に応じて料金が発生し、エンタープライズグレードのセキュリティと責任あるAIのフレームワークを提供。

- モデルの定義 - パラメーターや重みを含むニューラルネットワークそのもの。

- モデルのローカル運用 - 機器の購入や環境構築、ライセンス購入が必要になることもある。

- オープンソースモデルの利用 - オープンソースモデルを使用してローカルで運用することも可能。

- モデルの実行に必要な資源 - モデルを実行するためには適切な計算資源が必要。

- LLaMAモデルの例 - 利用可能なモデルの一例として、計算資源を必要とするLLaMAがある。

Azure でパフォーマンスを理解するために異なるモデルでテストと反復処理を行う方法

- LLMの現状分析 - LLMの現在の状況を調査し、シナリオに合ったモデルの候補を特定。

- 実データによるテスト - 企業の実データと負荷試験を用いてモデルをテストする必要性。

- 反復的なプロセス - モデルテストは実験と検証を通じた反復的なプロセス。

- Azure Machine Learning Studioの利用 - OpenAIモデルやオープンソースモデルが利用可能なプラットフォーム。

- MLライフサイクルの管理 - トレーニング、テスト、デプロイ、MLOps管理を一つのプラットフォームで実施。

- モデルカタログの活用 - 興味のあるファウンデーションモデルをカタログから探し、フィルタリングする機能。

- モデルカードによる詳細確認 - モデルの詳細な説明とコードサンプルを確認。

- モデル評価の手法 - 特定の負荷試験とデータセットを用いたモデルの客観的な評価。

- モデルのファインチューニング - カスタムトレーニングデータを用いたモデルのパフォーマンス向上。

- モデルのデプロイ - トレーニング済みまたはファインチューニング済みのモデルをリアルタイム推論やバッチエンドポイントにデプロイ。

大規模言語モデル (LLM) の出力結果を改善

概要

- LLMのパフォーマンス向上戦略 - スタートアップチームが異なるLLMとクラウドプラットフォームサービスを理解し、モデルを比較、評価し、パフォーマンスを向上させる方法。

- ファインチューニングのタイミング - 事前トレーニングされたモデルではなく、ファインチューニングするべき時期の検討。

- パフォーマンス向上のアプローチ - 特定の負荷試験でモデルのパフォーマンスを向上させる異なるアプローチの存在。

- 実装方法の選択肢 - トレーニングレベルの異なる手法に基づいた実装方法の検討。

- プロンプトエンジニアリングの利用 - 十分なコンテキストを提供してプロンプトを記述し、必要な回答を得る方法。

- Retrieval Augmented Generation(RAG) - データベースやWeb上の関連データを取得し、プロンプトに含める方法。

- ファインチューニングモデルの適用 - 自社データを用いたモデルのファインチューニングと、それに伴うコストの考慮。

- コストと品質のバランス - 実装方法を選択する際に、コストと品質のバランスを考慮。

- LLMのデプロイ戦略 - 様々なアプローチを検討し、LLMを本番環境にデプロイする戦略。

- 企業のニーズに応じたLLM利用 - 企業が期待する結果を得るためのLLMの利用方法の選択。

コンテキストを用いたプロンプトエンジニアリング、RAG、ファイン・チューニングしたモデルの利用、トレーニング済みモデル

- プロンプトエンジニアリングの基本 - 事前学習済みLLMで文作成や質問処理に短いプロンプトを使用する方法。

- ゼロショット学習 - プロンプトだけで良い結果を出すLLMの学習方法。

- ワンショット・フュー・ショット学習 - 追加コンテキストを提供し、より正確な回答を得る学習方法。

- コンテキスト活用の効果 - 詳細なリクエストや具体例を用いたプロンプト記述による回答の改善。

- Retrieval Augmented Generation(RAG) - LLMのデータ制約を外部データで補う手法。

- RAGの実装 - プロンプトに外部データを組み込んで、より正確な回答を得る方法。

- RAGの利点 - ファインチューニングが困難な企業にとっての有用性。

- ファインチューニングの概要 - 転移学習を活用してモデルを特定のタスクに適応させるプロセス。

- ファインチューニングの適用例 - 低能力モデルの使用や、レイテンシーの考慮、最新のデータ維持など。

- トレーニング済みモデルの利点 - ドメイン固有のユースケースや大量データを持つビジネスに最適。

- コスト効率の高いアプローチ - コンテキストを用いたプロンプトエンジニアリングはコスト効率が高い。

- プロンプトの長さ制限の考慮 - RAGではプロンプトの長さ制限を考慮して外部データを取り込む。

- データベースの活用 - RAGはVectorデータベースを活用してデータを取得。

- パフォーマンス向上のためのRAG - 特定の負荷試験でのパフォーマンス向上やリスク軽減にRAGを使用。

- 新しいモデルの生成 - ファインチューニングでは新しい重みとバイアスを持つモデルを生成。

- 大量トレーニングデータの必要性 - ファインチューニングには大量のトレーニングデータが必要。

- コスト効率の考慮 - ファインチューニングモデルはコスト効率が重要な場合に適している。

- 最新データの維持 - ファインチューニングモデルは最新のデータを維持するのに有効。

- LLMのゼロからのトレーニング - 最も困難で複雑なアプローチ。

- ドメイン固有ユースケースへの適用 - ドメイン固有のユースケースに適したトレーニング済みモデル。

3.責任ある生成 AI の利用

- 学ぶ内容の概念: 概念: ファウンデーションモデルの限界と AI に伴うリスクを理解する

- 学習目標: 責任ある生成 AI アプリケーションの開発方法を学ぶ

ビデオの要約 by YouTube Summary with ChatGPT & Claude

TODO ビデオは近日公開予定

コンテンツの要約 by ChatGPT

責任ある AI の原則

- 生成AIの盛り上がり - 生成AIに対する興味が高まり、新たな開発者、関心、資金が業界にもたらされている状況。

- 新製品・企業の機会 - 生成AIを利用して新しい製品や企業を創業する人々にとっての好意的な環境。

- 責任ある進行の重要性 - 生成AIの利用において責任を持って進めることの重要性。

- AI利用教育製品への焦点 - スタートアップがAIを利用した教育製品の実装に焦点を当てる。

- 公平性の原則 - 製品開発における公平性の重視。

- 包括性の原則 - さまざまなユーザーを含めた包括性の確保。

- 信頼性・安全性の原則 - 製品の信頼性と安全性の確保。

- セキュリティ・プライバシーの原則 - ユーザーのセキュリティとプライバシーの保護。

- 透明性の原則 - 製品の透明性とユーザーへの情報提供。

- 説明責任の原則 - AIの決定やプロセスに関する説明責任。

責任ある AI を優先すべき理由

- 顧客中心のアプローチの重要性 - 製品開発では利用者の利益を最優先することで最良の結果を期待。

- 生成AIの役立ち具合 - 回答、情報、ガイダンス、コンテンツ生成において利用者を支援。

- 手作業不要の効率性 - 多くの作業を手作業不要で実行でき、優れた成果をもたらす。

- 計画と戦略の必要性 - 適切な計画と戦略がないと、利用者や社会に悪影響を及ぼす可能性がある。

- 悪影響の可能性 - 不適切な生成AIの使用が引き起こす潜在的な害についての認識。

- 責任あるAIの優先 - 責任あるAIの実践を優先し、ユーザーや社会に対する悪影響を最小限に抑える。

- 利用者利益の最大化 - 利用者の利益を最大化するためのアプローチとして責任あるAIの活用。

- 潜在的なリスクの回避 - 潜在的なリスクを回避し、製品やサービスの価値を高める。

- 社会的な影響への配慮 - 生成AIが社会に与える影響に対する配慮と責任。

- 生成AIの適切な使用 - 生成AIを利用者にとって有益かつ安全に使用するためのガイドライン。

Hallucinations (幻覚)

- 幻覚の定義 - LLMが無意味な内容や事実と異なる内容を出力する際に使用される用語。

- 歴史問い合わせの例 - 学生がAIモデルに歴史に関する質問をするシナリオ。

- 間違った回答の例 - タイタニックの唯一の生き残りに関する間違った回答。

- 回答の誤解 - 学生が間違った情報を事実と誤解するリスク。

- 信頼性の喪失 - 間違った回答により学生がAIシステムを信頼しなくなる可能性。

- 企業評判への悪影響 - 誤った情報がスタートアップ企業の評判に悪影響を及ぼすリスク。

- LLMのパフォーマンス改善 - LLMのバージョンアップによる幻覚の減少。

- 改善への努力 - 幻覚を減らす方向でのパフォーマンス改善の取り組み。

- 開発者の認識 - アプリケーション開発者が回答捏造の問題を意識する必要性。

- 利用者の警戒 - 利用者が誤った情報を識別し、注意深く利用する必要がある。

有害なコンテンツ

- 有害なコンテンツのリスク - LLMが有害なコンテンツを回答する可能性についての注意。

- 自傷行為や危害の助長 - 自傷行為や特定グループへの危害を奨励する指示の含まれるコンテンツ。

- 憎悪や侮辱の内容 - 憎悪や侮辱的な内容を含むコンテンツ。

- 攻撃計画の内容 - 攻撃や暴力行為の計画に関するコンテンツ。

- 違法行為の方法 - 違法なコンテンツを探す方法や犯罪を犯す方法に関する情報。

- 性的露骨な内容 - 性的に露骨な内容を含むコンテンツ。

- スタートアップの対策 - 学生が有害なコンテンツに触れないようにするための対策。

- 適切なツールの導入 - 有害なコンテンツをフィルタリングするためのツールの選定。

- 戦略の策定 - 有害なコンテンツに対応するための戦略の策定。

- 安全な環境の確保 - 学生に安全な学習環境を提供するための取り組み。

公平性の欠如

- 公平性の定義 - AIシステムが偏見や差別なく、全人類に対して公平かつ平等にサービスを提供する状態。

- 生成AIの偏見リスク - マイノリティグループに対する排他的な世界観がモデルで再強化される危険性。

- 公平性欠如の影響 - 利用者にとっての不利益な製品体験や社会的な損害の引き起こし。

- 多様性の考慮の重要性 - アプリケーション開発者が多様な利用者層を考慮する必要性。

- 生成AIの責任ある利用 - 社会的な偏見や差別を避けるための生成AIの責任ある利用。

- 差別的な出力の防止 - AIが差別的な出力をしないようにするための措置。

- 利用者体験の向上 - 公平性を確保することで利用者の製品体験を向上させる。

- 開発者の役割 - アプリケーション開発者が公平性を確保する役割を担う。

- 社会的責任 - 生成AIを用いる企業や開発者の社会的責任。

- 公平性の監視 - AIシステムの公平性を維持するための監視と評価。

責任ある生成 AI の使用方法

潜在的な危害の測定

- ソフトウェアテストの基本 - 利用者の行動を予想し、それに基づいてアプリケーションのテストを行う一般的な方法。

- プロンプトによるテスト - 様々なテストケースを用いて利用者が入力する可能性のあるプロンプトを実行する。

- 潜在的問題の事前発見 - テストによって潜在的な問題を事前に発見する可能性。

- 教育関連製品の実装 - スタートアップが教育関連の製品を実装している場合の対策。

- 教育関連プロンプトの準備 - 特定の科目や歴史的事実、学生生活に関するプロンプトのリスト作成。

- テストケースの多様性 - 教育関連のプロンプトを多様なテストケースとして利用。

- 製品の安全性の確保 - テストを通じて製品の安全性を高める。

- 利用者の予想行動の理解 - 利用者がどのようなプロンプトを入力する可能性があるかを理解する。

- 問題の予防対策 - 潜在的な問題を事前に識別し、予防する対策。

- 教育的なコンテキストの考慮 - 教育製品における特定のコンテキストを考慮したテストの実施。

潜在的な危害の軽減

- AIモデルの選択 - 用途に適したAIモデルを選択し、有害なコンテンツのリスクを減らす。

- 安全システムの利用 - モデル提供プロバイダの安全システムを活用し、危害を軽減。

- メタ・プロンプトの活用 - モデルの行動を特定の方向に誘導し、制限する。

- 信頼性のある情報源 - RAG技術を用いて、信頼性の高いデータソースからの情報利用を確保。

- ユーザー・エクスペリエンスの設計 - 利用者に適切なUI/UXを提供し、入力や表示を制限。

- 透明性の確保 - AIアプリケーションでできることとできないことを明確に伝える。

- UXデザインの重要性 - AIアプリケーションのUXデザインに特化したレッスン。

- モデル評価の必要性 - モデルの性能や出力を常に検証し、正確性や関連性を評価。

- 透明性と信頼性の提供 - 利害関係者や利用者に対する透明性と信頼性の提供。

- モデルの扱いの難しさ - LLMの扱いが難しい点と、それに対する対応策。

責任ある生成 AI ソリューションを運用する

- 本番環境用AIアプリケーションの構築 - スタートアップにおけるAIアプリケーション開発の最終段階。

- 法務・セキュリティ部門との協力 - 規制方針への準拠確認において法務部門やセキュリティ部門と協力することの重要性。

- デリバリー計画の策定 - サービスローンチ前のデリバリー計画の作成。

- 問題発生時の対応策 - トラブル発生時の対応手順の確立。

- ロールバック手順の準備 - 不具合発生時に原状復帰するためのロールバック手順の策定。

- 利用者被害防止の戦略 - 利用者に被害が及ばないような安全戦略の練り方。

- 規制方針の確認と遵守 - AIアプリケーションが全ての規制方針に準拠しているかの確認。

- セキュリティ対策の重要性 - AIアプリケーションの安全性を確保するためのセキュリティ対策の実施。

- 危機管理の計画 - 緊急時の危機管理計画の策定。

- 責任ある運用の実践 - 責任ある生成AIソリューションの運用に向けた実践的なアプローチ。

ツール

- 責任あるAI開発の労力 - 責任あるAIソリューション開発には手間がかかるが、その価値は大きい。

- 生成AIビジネスの進化 - 生成AIのビジネスが成長するにつれて、開発プロセスが進化。

- 効率的なツールの充実 - 責任あるAIを効率的に取り入れるためのツールが充実していく。

- Azure AI Content Safetyの活用 - API呼び出し時に有害なコンテンツや画像を検出するツール。

- 自動化による効率化 - 有害コンテンツの検出を自動化することで、効率的な開発をサポート。

- 安全なAPI呼び出し - APIを安全に使用するためのサポートツールの提供。

- リスク管理の支援 - AI開発におけるリスク管理を支援するツールの重要性。

- 開発作業の簡素化 - 責任あるAIの実装を簡素化するツールの活用。

- 進化する開発環境 - 生成AIのビジネス成長に伴い、開発環境も進化する。

- 安全性の向上 - AIソリューションの安全性を高めるためのツールの役割。