元論文 2011.00362.pdf

自己教師あり学習(Self-supervised Learning):

対照学習(Contrastive Learning):

教師付き対照学習(SCL, Supervised Contrastive Learning):

自己教師付き対照学習(SSCL, Self-Supervised Contrastive Learning):

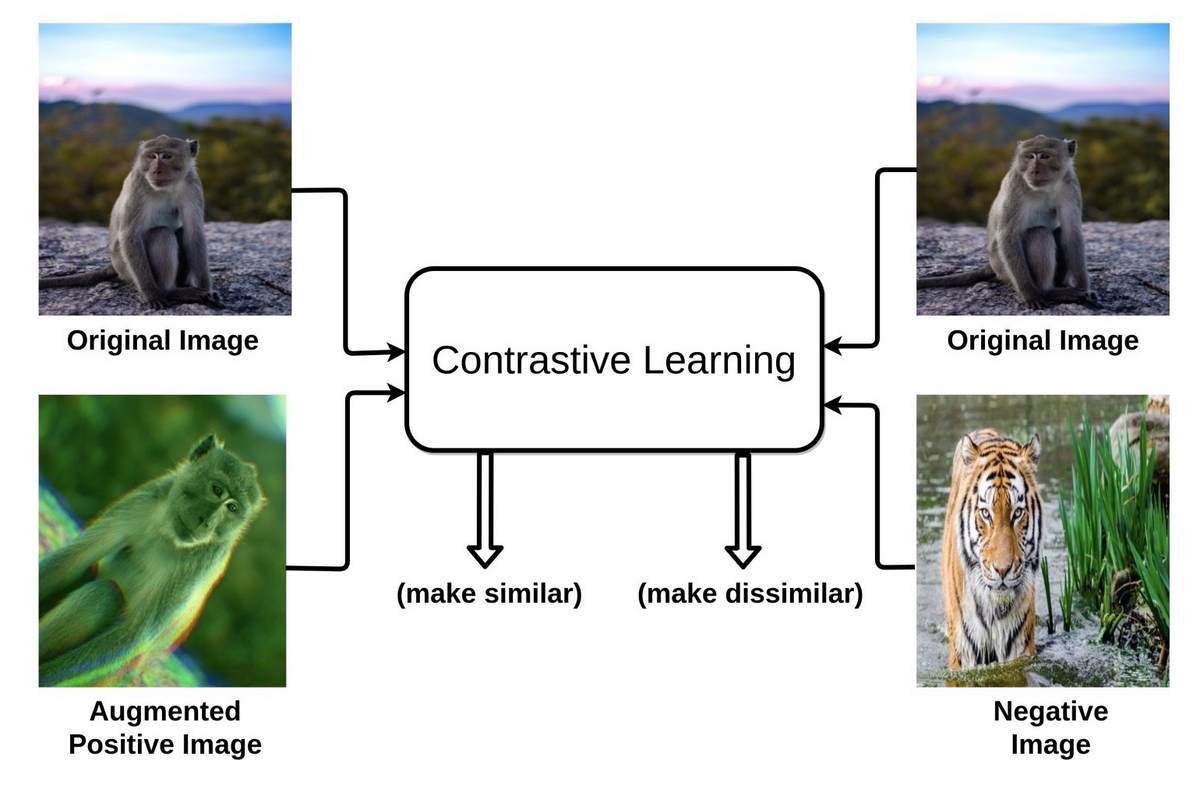

- 明示的なラベルに頼らずにラベルのないデータから表現を学習するアプローチ

- ラベルのないデータから肯定的および否定的なペアを作成するプリテキストタスクの設計を活用

- モデルがデータ内の意味のある特徴と類似性を捉えるようにプリテキストタスクが慎重に設計

SSCLの応用例:

SimCLR:

A Simple Framework for Contrastive Learning of Visual Representations

google-research/simclr: SimCLRv2 - Big Self-Supervised Models are Strong Semi-Supervised Learners

Advancing Self-Supervised and Semi-Supervised Learning with SimCLR – Google Research Blog

summary

SimCLRの紹介: Google Researchのチーム、Ting ChenとGeoffrey Hintonを含む、画像分類における自己教師あり学習と半教師あり学習のための新しいフレームワークであるSimCLRを紹介します。

自己教師あり学習の背景: BERTやT5などの自然言語処理の最近の進歩は、大規模なラベルなしデータセットでの事前学習とその後の小規模ラベル付きデータセットでの微調整の効果を示しています。このアプローチは現在、コンピュータビジョン分野で探求されています。

現在の技術の課題: 画像データに対する既存の自己教師あり学習方法は複雑であり、アーキテクチャや訓練手順の大幅な変更が必要なため、広く採用されていません。

SimCLRフレームワーク: SimCLRは、画像の自己教師あり表現学習の既存の方法を簡素化し、改善します。これには、ラベルなし画像での学習を通じて一般的な表現を学び、それを少量のラベル付きデータセットで特定のタスクのために微調整することが含まれます。

対照的学習方法: SimCLRは、同じ画像の異なる変換間の合意を最大化し、異なる画像間の合意を最小化するためにニューラルネットワークを訓練する対照的学習を使用します。

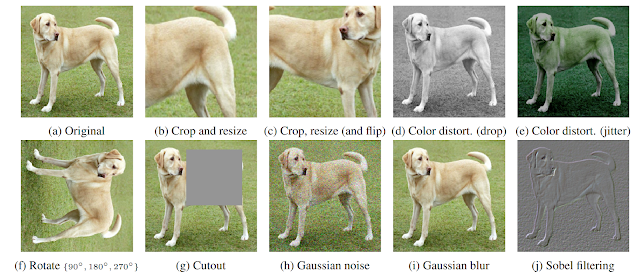

画像変換と表現: フレームワークは、切り取り、色の歪み、ガウスぼかしなどの単純な変形を使用して画像を変換します。これらの表現は、ResNetベースの畳み込みニューラルネットワークと全結合ネットワークを使用して計算されます。

訓練と微調整: ネットワークは、対照的目的の損失を最小限に抑えるために確率的勾配降下を使用して訓練されます。ラベルなし画像での事前トレーニングの後、モデルは特定のタスクでの性能を向上させるためにラベル付き画像で微調整することができます。

成果: SimCLRは画像分類において新記録を達成し、ImageNetデータセットのラベル付き画像のわずか1%を使用して85.8%のトップ5精度を達成しました。

パフォーマンス

1. SimCLRによる性能向上:

- ImageNetにおいて、SimCLRは自己教師あり学習と半教師あり学習を大幅に向上させる。例えば、SimCLRの表現を使用した線形分類器は76.5%のトップ1精度と93.2%のトップ5精度を達成し、以前の最高(CPC v2)を上回る。

- ラベルの1%のみでファインチューニングすると、SimCLRは63.0%のトップ1精度と85.8%のトップ5精度を達成する。

- 完全なラベルでのファインチューニングでは、SimCLRは教師ありベースラインを上回り、30エポックで80.1%のトップ1精度を達成する。

2. 対照的学習における主要な発見:

- 発見1: 画像変換の組み合わせ(ランダムクロッピングとカラー歪み)が重要である。